ControlNet模型大全

ControlNet模型功能类别

人物姿势 | OpenPose(姿势) | 1.5、XL、Flux | 身体、身体+手指、身体+表情、只有表情、身体+手指+表情 | ||

线条 | Canny(硬边缘) | 1.5、XL、Flux | 识别出来的线条最多,更好的还原原图,对二次元照片比较适用 | ||

| Lineart(线稿) | 1.5、XL | 可以针对不同类型的照片提取线稿 | |||

| SoftEdge(软边缘) | 1.5 | 只识别大概的轮廓,给SD更多的发挥空间 | |||

| MLSD(直线) | 1.5 | 只识别直线,用在建筑物设计上 | |||

| Scribble/Sketch(涂鸦/草图) | 1.5、XL | 涂鸦,非常粗糙的线条 | |||

| mistoLine(最强线条处理) | XL | 配合AnyLine预处理器使用,rank256比fp16效果好 | |||

空间深度 | Depth(深度) | 1.5、XL、Flux | 可以很好的还原物品的前后关系 | ||

物品种类 | Segmentation(语义分割) | 1.5、XL | 通过不同的颜色控制分割图片不同的物品 | ||

风格 | Shuffle(随机洗牌) | 1.5 | 将图片颜色混合融到新图里 | ||

| Reference(参考) | 1.5 | 参考原图的风格或者角色 | |||

| NormalMap(法线贴图) | 1.5 | 参考原图的光影和姿势 | |||

| T2I-Adapter(适应提示词) | 1.5、XL | 风格转移、草稿差分、色彩控制 还原原图的颜色,根据提示词修改图像 | |||

| IP-Adapter(风格迁移) | 1.5、XL、Flux | 参考迁移整张图风格、也可以参考迁移人脸 | |||

重绘 | Inpaint(局部重绘) | 1.5、XL | 类似图生图的局部重绘 | ||

| Recolor(重上色) | 1.5 | 给照片重新上色 | |||

| 特效 | InstructP2P | 1.5 | 在原图的基础上加上特效 | ||

| 模糊处理 | Tile(分块) | 1.5、XL | 照片模糊识别,再加细节 | ||

按模型名称区分类型

diffusers:抱脸制作的模型

sai:SD官方制作的模型

t2i:腾讯制作的模型

full、mid、small:表示模型的大小,越大精细度越好,但实际差别不大

am 代表是动漫大模型

pn 代表是以 Pony 为基础模型炼制的大模型

kohya、sargezt、thibaud:个人制作者名字

128 LoRA、256 LoRA:模型制作时采用的两种低秩矩阵,用小的128的即可,效果差不多。

SDX1.5模型的ControlNet

下载地址:https://huggingface.co/lllyasviel/ControlNet-v1-1/tree/main

https://modelscope.cn/models/licyks/sd_control_collection/files

https://github.com/TencentARC/T2I-Adapter/tree/main

模型详解:https://www.wangjingxian.cn/aihuihua/173255780365338.html

SDXL模型的ControlNet

基础模型

下载地址:https://huggingface.co/lllyasviel/sd_control_collection/tree/main

里面的模型有3个是用于SD1.5,其他的都是用于XL的。

https://github.com/TencentARC/T2I-Adapter/tree/main

其他XL模型的ContrlNet

XL万能控制模型:Anytest

下载地址:https://huggingface.co/2vXpSwA7/iroiro-lora/tree/main/test_controlnet

作用:该模型捕捉参考图像的线条,通过输入图像来大致保持构图和明暗的,其构图保持力和对提示词的适应力都高度评价,它的功能非常广泛。

AnyStyle 给人的印象是“像 Depth 一样可以控制构图,同时可以像 i2i 一样修改色彩、发型和服装,类似于 Scribble 的变种”,在处理横向图像时效果不佳。

万能模型:xinsir/controlnet-union-sdxl-1.0

下载地址:https://huggingface.co/xinsir/controlnet-union-sdxl-1.0

作用:再也不用下载不同 ControlNet 模型了!目前有两个模型,其中ProMax版本带平铺和修复功能。controlnet-union-sdxl 同时支持了12种模式:

Openpose | Depth | Canny | Lineart | AnimeLineart | Mlsd |

| Scribble | Pidi(Softedge) | Teed | Segment | Normal | Hed |

**模型优势**

* 采用像NovelAI那样的bucket训练方法,能生成任意宽高比的高分辨率图像

* 使用大量高质量数据(超过1000万张图像),数据集涵盖多样化场景

* 使用类似DALLE.3的重新描述提示词技术,利用CogVLM生成详细描述,具有良好的提示词跟随能力

* 训练过程中使用了多种有效技巧,包括但不限于数据增强、多重损失函数、多分辨率等

* 与原始ControlNet相比,使用几乎相同的参数,网络参数量和计算量没有明显增加

* 支持10多种控制条件,在任何单一条件下的性能与独立训练相比都没有明显下降

* 支持多条件生成,条件融合在训练过程中学习得到,无需设置超参数或设计特殊提示词* 兼容其他开源SDXL模型,如BluePencilXL、CounterfeitXL等,同时兼容其他LoRA模型

注意:openpose这个是不能用带人脸关键点的骨架图,因为训练的时候没有训这个。

CN-anytest_v4-marged.safetensors

作用:保持面部特征,SD 每一步都是在上一步的基础上进行扩散和降噪,因此变化会越来越大。而使用了 ControlNet 模型 CN-anytest_v4-marged 之后,每一步都会参考原图来进行扩散和降噪,因此最后仍然能保持原图的面部特征。

下载:https://huggingface.co/2vXpSwA7/iroiro-lora/tree/main

特点:直接使用,不需要预处理图像即可生效。

使用此模型时,可以直接传递图片,而不需要用“预处理器"提前把图片处理成骨骼图、深度图等图片。

Flux模型的ControlNet

下载地址:https://huggingface.co/XLabs-AI/flux-controlnet-collections

Controlnet模型(Xlabs-AI)

Hed :https://huggingface.co/XLabs-AI/flux-controlnet-hed-v3/tree/main

Depth : https://huggingface.co/XLabs-AI/flux-controlnet-depth-v3/tree/main

Canny : https://huggingface.co/XLabs-AI/flux-controlnet-canny-v3/tree/main

Controlnet模型存放位置:ComfyUI\models\xlabs\Controlnets

Controlnet模型(TheMistoAI)

mistoline_flux.dev_v1.safetensors:https://huggingface.co/TheMistoAI/MistoLine_Flux.dev/tree/main

Controlnet模型mistoline_flux.dev_v1放置在:ComfyUI\models\TheMisto_model

该模型需要搭配MistoControlNet-Flux-dev插件的节点使用

Controlnet模型(shakerlaps+Instanx联合出品Union Pro版) 万能模型增强版

V1:https://huggingface.co/Shakker-Labs/FLUX.1-dev-ControlNet-Union-Pro/tree/main

该模型支持7种控制模式,包括canny、tile、depth、blur、pose、gray、low quality。

V2:https://huggingface.co/Shakker-Labs/FLUX.1-dev-ControlNet-Union-Pro-2.0/tree/main

该模型支持5种控制模式,canny, soft edge, depth, pose, gray

配合“set shakerlaps union controlnet type”这个节点使用。

总结:不使用IP Adapter时,V2版本碾压V1版本,使用IP Adapter时,两者相差不大,V2显存占用相对更小,V1可以淘汰了。

jasperai的Controlnet模型

① Flux.1-dev-Controlnet-Surface-Normals 深度法线贴图

地址:https://hf-mirror.com/jasperai/Flux.1-dev-Controlnet-Surface-Normals/tree/main

特点:生图速度快

② Flux.1-dev-Controlnet-Depth深度

地址:https://hf-mirror.com/jasperai/Flux.1-dev-Controlnet-Depth/tree/main

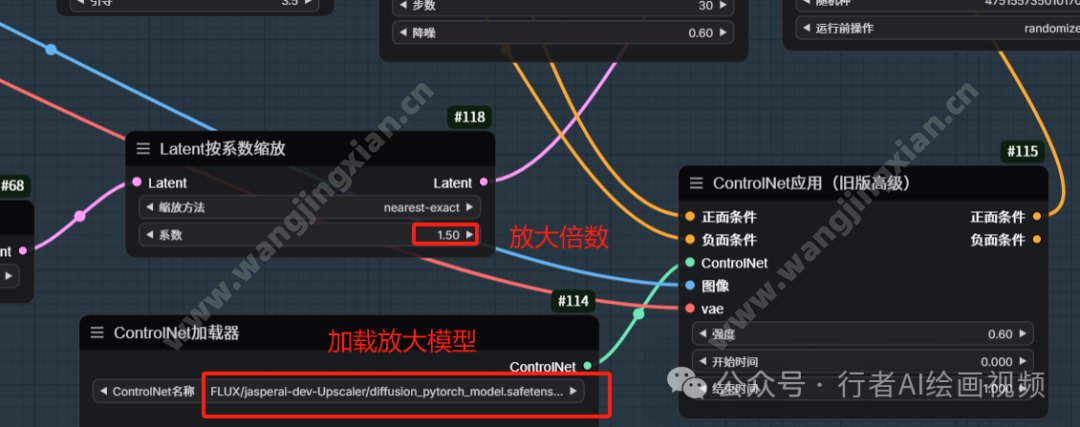

③ Flux.1-dev-Controlnet-Upscaler Flux高清修复放大

https://hf-mirror.com/jasperai/Flux.1-dev-Controlnet-Upscaler/tree/main

Controlnet模型存放位置:ComfyUI\models\Controlnets

工作流原理:Flux基础工作流上增加ControlNet模型加载和ControlNet应用节点即可。(比较占显存)

操作说明:

放大倍数:放大几倍填多少,图示是1.5倍

ContrplNet:加载放大模型

强度:默认0.6,可以调高测试,在0.6-1之间

openpose模型

flux-openpose-raulc0399.safetensors

插件式ControlNet

ComfyUI-DepthAnythingV2:深度估计模型

参考

controlnet预处理器详解

https://www.wangjingxian.cn/comfyui/17284774338842.html