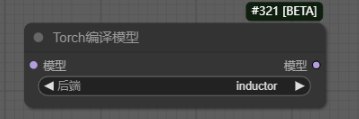

Torch编译模型

作用:加速flux 40%速度的节点。

支持模型:flux、ooVideoX

需求:

Triton-windows

Nvidia CUDA

Visual Studio 2022

VC++ 2015-2022

Python 文件夹(include、libs)

此节点需要以上5个环境配置,但便携版缺少的两个python文件夹(include+libs)

使用方法:

flux基础工作流加载进来,直接链接torch编译模型就可以用。在第一次运行时会编译文件,你会发现你的comfvui目录会多几个文件(main.exp main.lib main.obj),所以速度会慢一点,但是后面出图就能感受到它带来的加速了,而这种加速是不会改变图片质量的。默认出图9秒的,而用了torch编译就变成6秒了,加速效果非常明显。

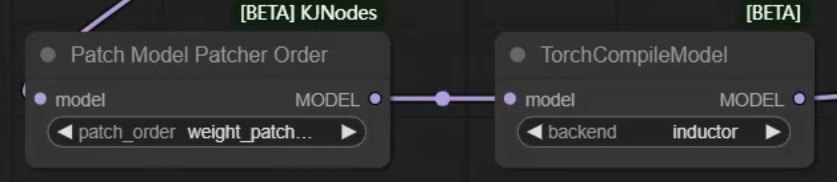

注意:直接使用上图的官方“Torch编译模型”节点是不支持Lora的。在它的前面加上“Patch Model Patcher Order”节点,这样就支持在前面添加Lora了。 另外第三方插件还有几个单独的节点,把两者功能合并到一起了,参数默认即可。

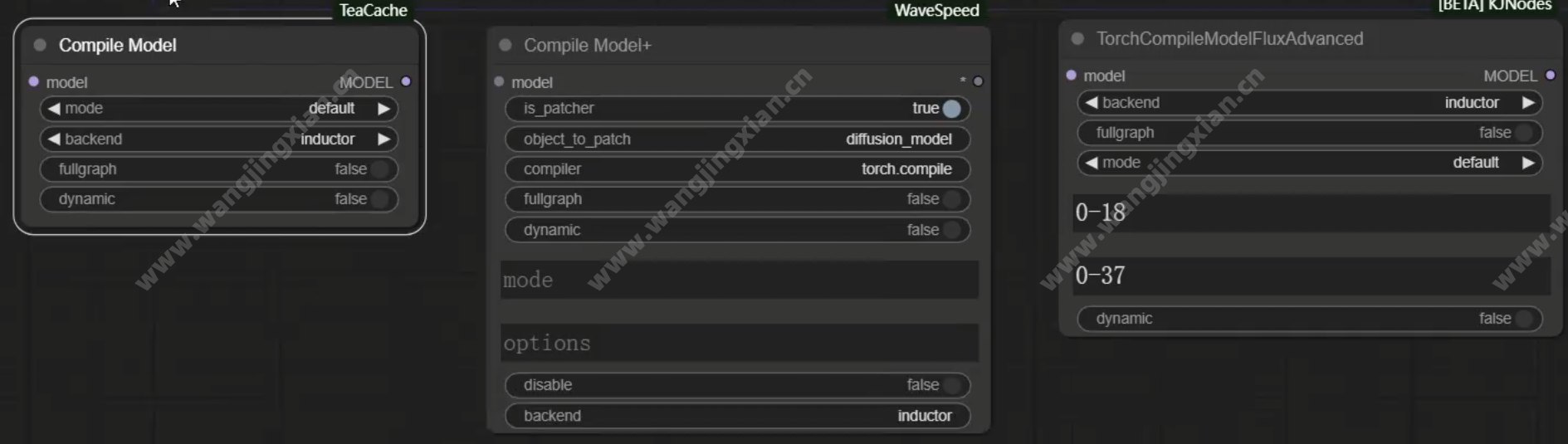

另外第三方插件还有几个单独的节点,把两者功能合并到一起了,参数默认即可。

但介于参数太过复杂,一般都是默认即可,所以还不如直接用官方节点添加支持Lora的方案。