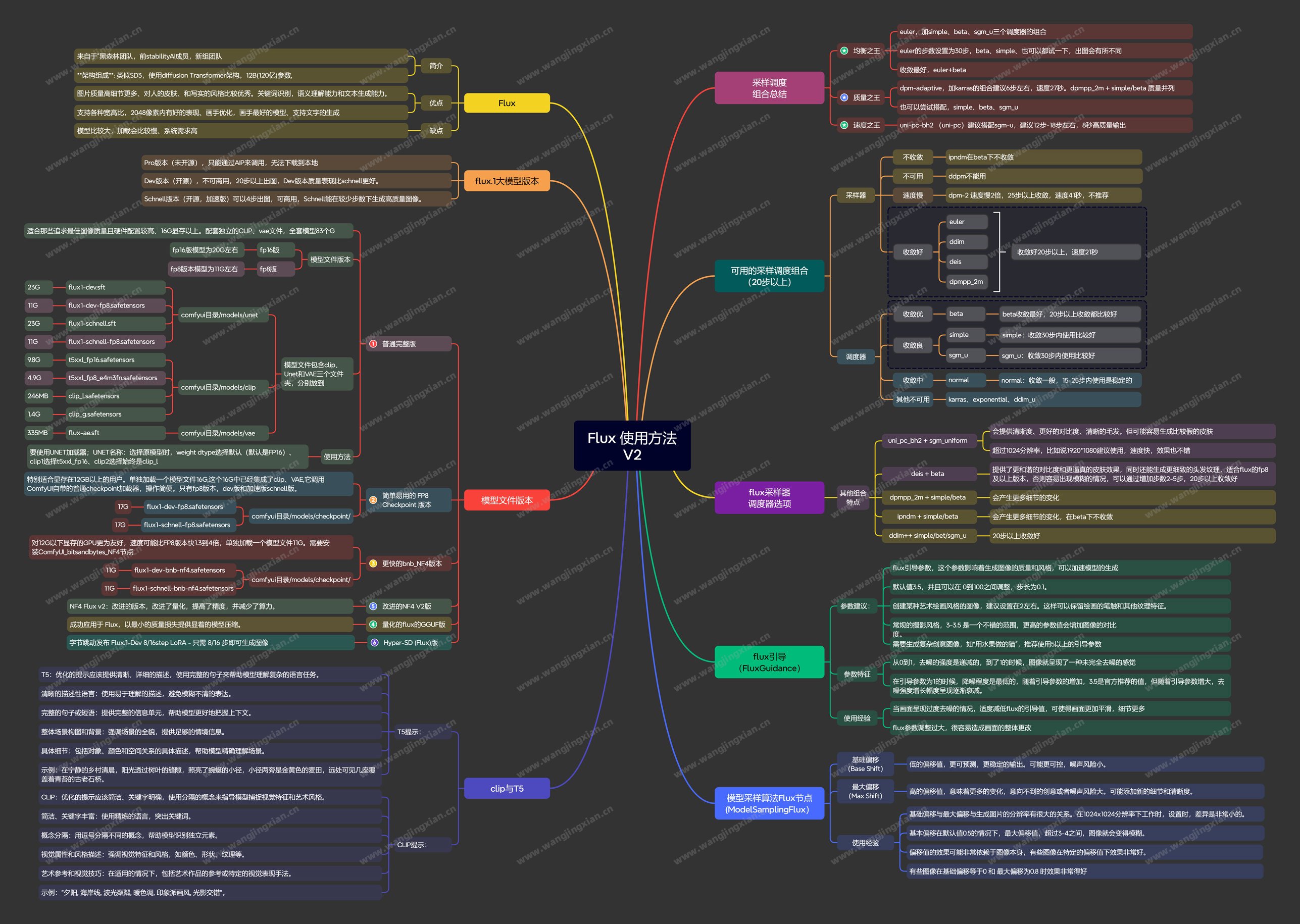

FLUX模型综合讲解

FLUX模型是由Black Forest Labs推出的最新文本生成图像模型, 它是SD的创始团队,它的成员很多都是从SD里面出来的。

它开源的这个模型有120亿个参数,也就是12B。要知道Stable Diffusion 3 Medium 才包含20亿个参数,闭源的那个SD3 模型也才80亿参数。

FLUX.1 官方介绍页面:https://blackforestlabs.ai/

FLUX.1 官方博客:https://blackforestlabs.ai/announcing-black-forest-labs/

官方三个版本

FLUX.1 [pro] 闭源,只能使用api

FLUX.1 [dev] 开源,20步出图,不可商用

FLUX.1 [schnell] 开源,4-8步出图,可以商用

特点

画质极佳,为目前各种开源大模型中最好的

分辨率弹性,支持各种宽高比和分辨率,最高可达2048

改进修手,生手效果非常好

字体生成与排版,能够是直接生成英文并且排版

能够轻松生成各种风格

embeddings通用性好,SD15和SDXL的都可以用

不需要输入负面提示词

模型下载:

配套模型

无论用哪套基础模型生图,都需要安装这个配套模型。

clip模型下载:https://huggingface.co/comfyanonymous/flux_text_encoders/tree/main

CLIP 模型存放位置:ComfyUI\models\clip

GGUF量化版模型下载:https://hf-mirror.com/city96/t5-v1_1-xxl-encoder-gguf/tree/main

GGUF量化版模型存放位置:ComfyUI\models\clip

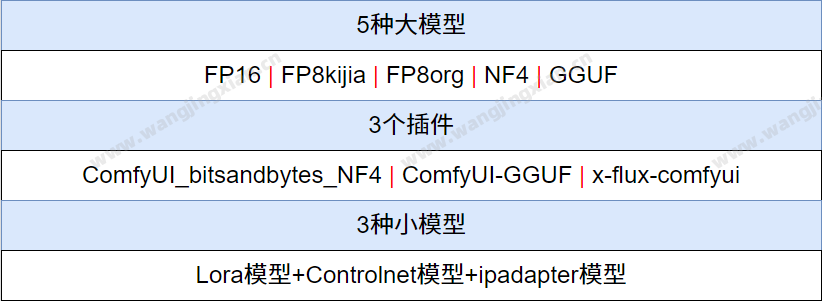

基础模型

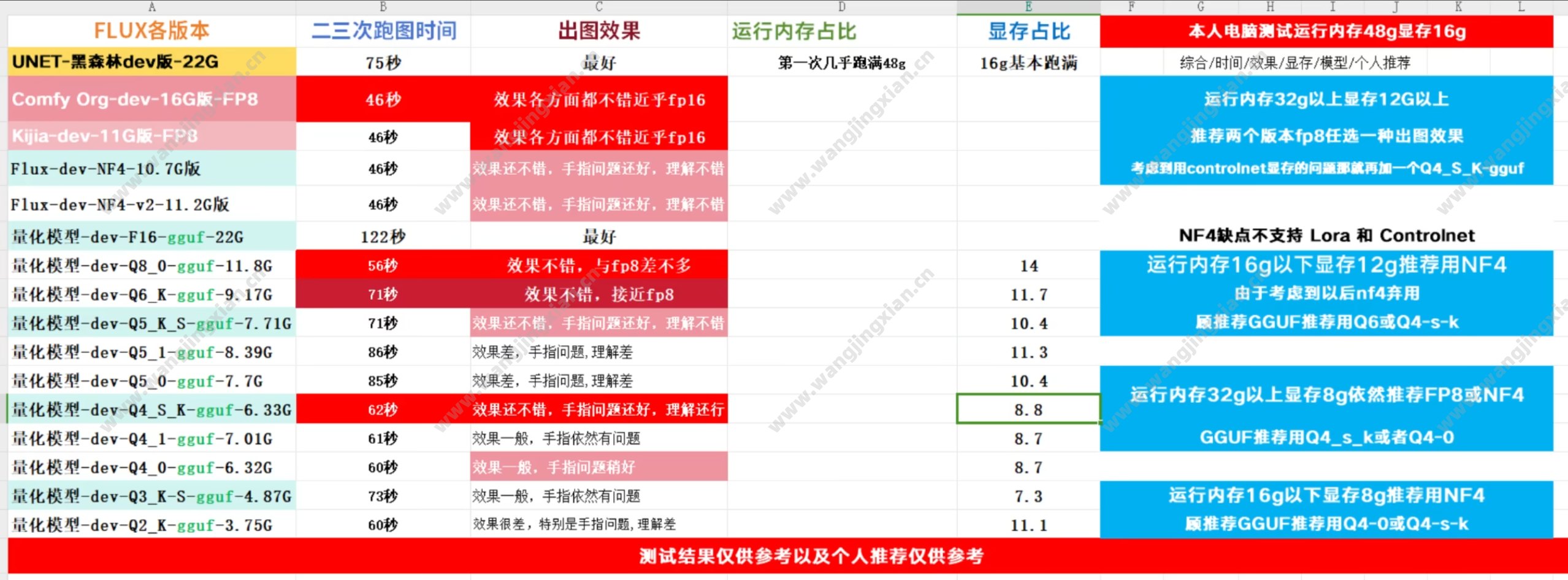

FP16大模型(官方原版)+VAE模型:质量速度都好,就是费显卡

特征:效果最好,速度较慢。对配置要求最高,显存16g以上,内存64G

FP16 大模型[dev] +VAE下载:https://huggingface.co/black-forest-labs/FLUX.1-dev/tree/main

FP16 大模型[schnell]+VAE下载:https://huggingface.co/black-forest-labs/FLUX.1-schnell/tree/main

大模型存放位置:ComfyUI\models\unet

VAE模型存放位置:ComfyUI\models\vae

FP8大模型(kijia版):质量速度都稳得1p,看着有点复杂

特征:效果较好,速度较快。显存8g以上,内存16/32G,用得最多

FP8大模型[dev] [schnell]下载:https://huggingface.co/Kijai/flux-fp8/tree/main

FP8大模型(kijia版)存放位置:ComfyUI\mndels\unet

flux1-dev-fp8-e4m3fn.safetensors 大小11.9G 开源本地可部署 非商业许可

flux1-dev-fp8-e5m2.safetensors 大小11.9G 开源本地可部署 非商业许可

flux1-dev-fp8.safetensors 大小11.9G 开源本地可部署 非商业许可

flux1-schnell-fp8-e4m3fn.safetensors 大小11.9G 开源本地可部署 商业许可

FP8大模型(comfy-org,comfyui官方版):质量速度都稳得1p,看着清爽

特征:效果较好,速度较快。显存8g以上,内存32G,与kijia版几乎一致,但可用简化采样器节点

FP8大模型dev整合版(T5xxl、CLIP、VAE)下载:https://huggingface.co/Comfy-Org/flux1-dev/tree/main

FP8大模型schnell整合版(T5xod、CLIP、VAE)下载:https://huggingface.co/Comfy-Org/flux1-schnell/tree/main

FP8大模型(comfy-org)存放位置:ComfyUI\models\checkpoints

fulx1 -dev-fp8-clip-vae.safetensors 大小17.2G 开源本地可部署 非商业许可

fulx1 -schnell-fp8-clip-vae.safetensors 大小17.2G 开源本地可部署 非商业许可

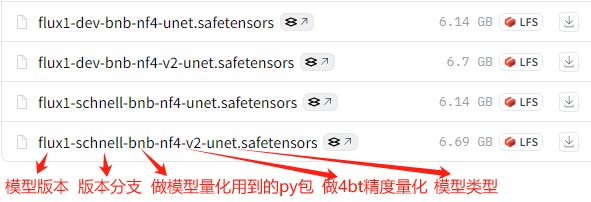

NF4量化模型(张吕敏开发版,V2更好)+插件:不费显卡,速度快啊

特征:效果比FP8差,偶尔也差不多,整体与Q4旗鼓相当,但质量不太稳定,速度最快。显存4g以上,内存32G,可用简化采样器节点,低显存中用得最多,用户评价也挺好,但据说官方不打算更新了。

NF4插件: https://github.com/comfyanonymous/ComfyUI_bitsandbytes_NF4(管理器粘贴git网址安装)

NF4大模型(裸版):https://hf-mirror.com/duuuuuuuden/flux1-nf4-unet/tree/main

NF4大模型dev整合版(T5xod、CLIP-L、VAE):

https://www.liblib.art/modelinfo/0175a2f9826d4c3a9335380940f87f58?from=search

NF4大模型整合版存放位置:ComfyUI\models\checkpoints

GGUF量化模型(city96开发版,推荐Q4)+插件:不费显卡,质量稳啊,选择多啊

特征:Q8/Q6/Q5/Q4/Q3/Q2多个版本,主要对应不同显存,比如Q4显存6g以上,效果上Q8与FP8相当,Q4与NF4相当,但比NF4稳定,速度最慢。用户评价不怎样,但NF4作者觉得GGUF挺好。均为非商业许可。

GGUF插件: https://github.com/city96/ComfyUI-GGUF (启动界面可搜索安装)

GGUF大模型:https://huggingface.co/city96/FLUX.1-dev-gguf/tree/main

GGUF大模型存放位置:ComfyUI\models\unet

一般完整版(fp16)需要24G显存才能正常驾驭,阉割版(fp8)16G就足够,nf4版本8-12G显存可正常驾驭,而gguf格式量化的如最小的Q2版本6G显存也能够正常驾驭,而且由于gguf近期展现出强劲的技术发展,充分体现降低内存需求而质量更好的特点,黑暗森林官方开始全面支持,所以nf4的版本将逐渐淘汰。

3种小模型:Xlabs插件+Lora模型+Controlnet模型+IP-Adapter模型

Xlabs插件

需要安装此插件才能使用下面3种小模型。

Xlabs插件: https://github.com/XLabs-AI/x-flux-comfyui (启动界面可搜索安装)

Lora模型(Xlabs-AI):

Xlabs-AI Lora模型:https://huggingface.co/XLabs-AI/flux-lora-collection/tree/main

Anime LoRA:精致的日式动漫风格 | Art LoRA:插图艺术 |

Disney LoRA:呈现迪士尼动画的魔法 | Furry LoRA:打造拟人化卡通角色 |

MJV6 LoRA:模仿 Midjourney V6 风格 | Realism LoRA:照片级真实感的极致 |

Scenery LoRA:描绘壮丽自然与城市景观 |

详情参考:https://zhuanlan.zhihu.com/p/714657191

lora模型存放位置:ComfyUI\models\xlabs\loras

Controlnet模型

https://www.wangjingxian.cn/aihuihua/17294979638442.html

IP-Adapter模型(Xlabs-AI)

ipadapter模型:https://hf-mirror.com/XLabs-AI/flux-ip-adapter/tree/main

V2版本:https://huggingface.co/XLabs-AI/flux-ip-adapter-v2/tree/main

ipadapter模型存放位置:ComfyUI\models\xlabs\ipadapters

clip模型存放位置:ComfyUI\models\clip_vision

作用:风格迁移,效果时好时坏,出图不稳定,提示词遵循效果也不好,不推荐。

FLUX.1-dev-IP-Adapter(不推荐)

FLUX.1-dev-IP-Adapter模型地址:https://huggingface.co/InstantX/FLUX.1-dev-IP-Adapter

ComfyUI-IPAdapter-Flux节点地址:https://github.com/Shakker-Labs/ComfyUI-IPAdapter-Flux

搭配的视觉模型:

sigclip_vision_patch14_384.safetensors:下载模型并放置目录ComfyUI/models/clip_vision下。

下载地址:https://huggingface.co/black-forest-labs/FLUX.1-Depth-de

作用:风格迁移,效果不错,但是非常消耗资源,3060 12g生图一个小时左右。

加速生图方案

Lora模型加速

Hyper-SD快速生图模型

下载地址:https://huggingface.co/ByteDance/Hyper-SD/tree/main

分别是8步和16步生图,下载后放在Lora目录即可,使用时跟使用其他Lora一样。

Flux Turbo Lora加速模型_StarAi

阿里妈妈创意团队开发的基于FLUX.1-dev模型的8步蒸馏版。

下载地址:https://huggingface.co/alimama-creative/FLUX.1-Turbo-Alpha/tree/main

教程:https://www.bilibili.com/video/BV1PWyTY2Eb6/

推荐权重:1;CFG:3.1。

大模型加速

Flux.1-lite-8B

支持与上面的 Flux Turbo Lora 一起使用,双重加速

下载地址:https://www.liblib.art/modelinfo/e145d0c1cf204822ba1a497edc01b1ba

另有GGUF量化模型:

推荐参数:采样方法 Euler,DPM++ 2M;CFG 3.5

插件加速

Teacache 和 Wavespeed 轻松2~3倍加速,

Teacache:

支持模型:用于Flux模型、混元视频、LTX视频生成加速!

插件地址:https://github.com/welltop-cn/ComfyUI-TeaCache

Wavespeed

支持模型:用于Flux模型、混元视频、LTX视频和SDXL模型生成加速!

插件地址:https://github.com/chengzeyi/Comfy-WaveSpeed

教程:https://www.wangjingxian.cn/comfyui/173921622554109.html

参考视频:https://v.douyin.com/iyEgrFTy/

Flux官方发布4个控制模型和2个控制Lora模型

Flux tools控制模型

1、canny线稿控制模型

下载地址:https://huggingface.co/black-forest-labs/FLUX.1-Canny-dev-lora

Canny Controlnet lora版:https://huggingface.co/black-forest-labs/FLUX.1-Canny-dev-lora

GGUF量化版:

说明:

虽然识别的线稿非常精准,但是生成的图丢失很多线稿细节,不好用,不推荐使用。

它还有一个对应的Lora模型,理论上基础Unet模型+Lora模型=这个canny线稿控制模型。

使用时,Flux引导写30

存放位置:ComfyUI\models\loras

下载地址:https://huggingface.co/black-forest-labs/FLUX.1-Depth-dev-lora

2、Depth深度控制模型

Depth Controlnet lora版:https://huggingface.co/black-forest-labs/FLUX.1-Depth-dev-lora

GGUF量化版:

说明:

效果可以,可以使用,但不突出,模型太大,没必要使用。

它也有一个对应的Lora模型,理论上基础Unet模型+Lora模型=这个depth深度控制模型。

使用时,Flux引导写30

存放位置:ComfyUI\models\loras

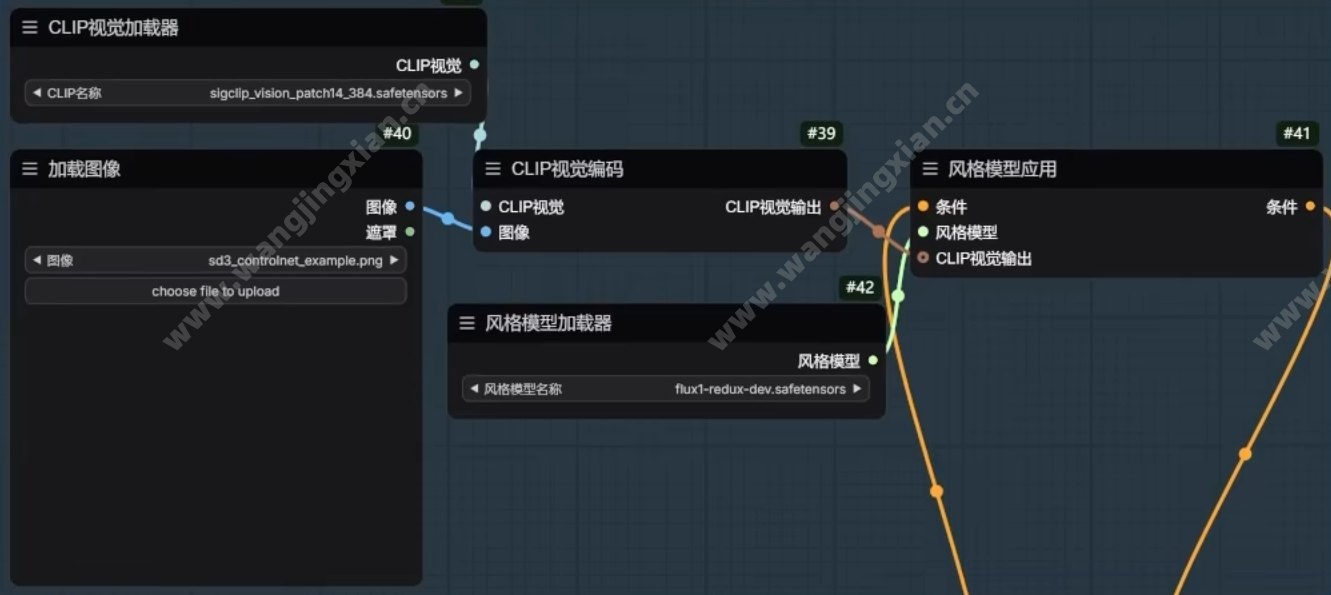

3、redux风格迁移模型

下载地址:https://huggingface.co/black-forest-labs/FLUX.1-Redux-dev

说明:

风格迁移、特征迁移、物品迁移、提取元素。

对提示词几乎无感,生图饱和度会变高。

使用此模型时需要用到3个模型

flux1-dev:基础大模型

sigclip_patch14-384.safetensors:存放位置ComfyUI\models\clip_vision ,用“CLIP视觉加载器”节点加载

flux1-redux-dev.safetensors:存放位置ComfyUI\models\style_models,用“风格模型加载器”节点加载

4、 fill重绘模型

下载地址:https://huggingface.co/black-forest-labs/FLUX.1-Fill-dev 这个22g太大了,建议使用量化版本。

量化版本:https://www.liblib.art/modelinfo/cb9cbb5532c34b1d8f5356d2435f0798

https://hf-mirror.com/SporkySporkness/FLUX.1-Fill-dev-GGUF/tree/main

说明:

专门用于局部重绘和扩图,非常好用。

使用时,Flux引导写30

存放位置:ComfyUI\mndels\unet

2个控制Lora模型

flux1-canny-dev-lora.safetensors

flux1-depth-dev-lora.safetensors

特殊大模型

PixelWave_FLUX.1-dev_03

作用:一个通用的微调FLUX模型,非常适合艺术和照片风格。

推荐设置:

30 steps, DPM++ 2M, SGM Uniform

15 steps, DPM++ 2S Ancestral, Beta

下载地址:https://hf-mirror.com/mikeyandfriends/PixelWave_FLUX.1-dev_03/tree/main

特殊Lora模型

In-Context LoRA

本次In-context lora提供了10个LoRA,分别为:情侣头像设计,电影剧照,字体设计,家居装饰,肖像插画,人像摄影,PPT模板,沙尘暴视觉效果,烟花视觉效果,视觉识别设计。它们的使用方法和普通的 Flux Lora 是一样的:在基础的 Flux 文生图流程上,加入一个 load lora 节点加载对应模型就行。

模型下载: https://huggingface.co/ali-vilab/In-Context-LoRA

应用场景展示: https://github.com/ali-vilab/In-Context-LoRA

需要注意的是,不同 lora 模型的提示词写法和推荐图像尺寸各有不同,具体内容官方在 github 上有给出示例。

注意

CFG之推荐:使用FLUX模型生图时cfg设置为1,当值小于1或大于1.5时,质量会下降,所以只需要无脑设置成1即可。

采样器和调度器推荐:ipdmn + simple uni_pc_bh2 + simple euler + beta euler + simple dpmpp + sgm_uniform。